今天突然发现Machine Learning:A Probabilistic Perspective一书中看过的章节中还有一些东西没完全弄懂,或者有些东西干脆就漏掉了,所以这一阵子打算把看过的部分梳理一下,慢慢来,脚踏实地地把这本书吃透,至少达到让自己满意的理解水平吧。作为机器学习拾遗的第一篇,我们主要从这本书中涉及概率图模型的章节入手,以期对概率图模型有一个更为深入的了解,并把之前遗漏的部分知识点捡起来。

Undirected Graphical Models1

- Family;For a directed graph,the family of a node is the node and its parents,$fam(s) = {s} \cup pa(s)$.

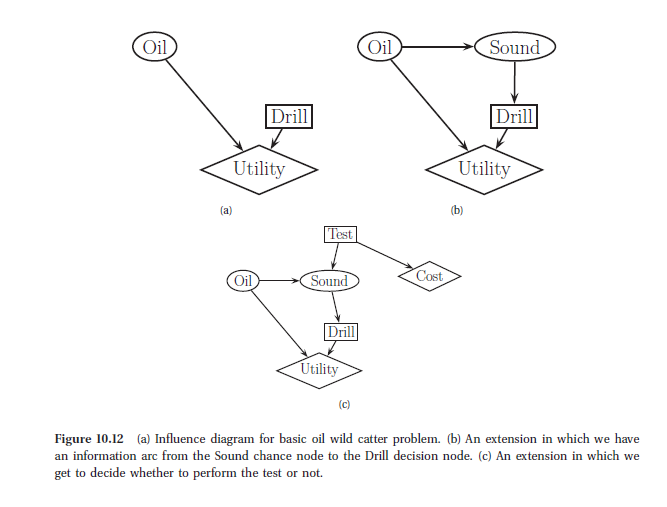

- Influence(Decision Diagrams);人的行为是理智的,人们在决策时总希望自己所能得到的期望效用最大化(Expected Utility),当我们对不同行动下的期望效用进行比较后就很容易做出对我们而言最好的Action.然而,现实生活中信息对于决策具有非常重要的意义,当我们获得一些其他的有用的信息时,可能做出更为明智的决定。得知一定的决策信息后,一般而言,我们的最大期望效用会提高,而此时的最大期望效用值相对之前的提升量则称为Value of Perfect Information,VPI(完美信息价值)。而实际上在现实生活中我们获取这些信息并不是不无代价的,因此 理智人能做出的理智选择是,当信息的VPI要大于获取信息的代价时,我们选择获取额外的信息,否则则不用获取该信息。

TODO Board:

- MDP(Markov Decision Process)

- Machine Learning:A Probabilistic Perspective Chapter 10 ↩